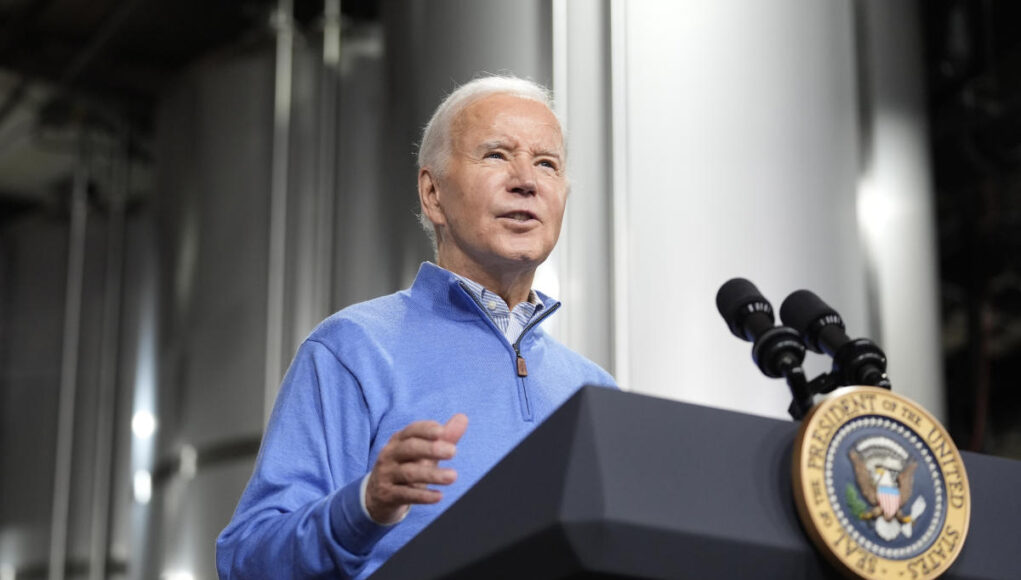

По данным Bloomberg, ElevenLabs, стартап в области искусственного интеллекта, предлагающий услуги клонирования голоса с помощью своих инструментов, заблокировал пользователя, создавшего аудио-дипфейк Джо Байдена, который использовался в попытке сорвать выборы. Аудиозапись, изображающая президента, была использована в звонке робота, который был разослан некоторым избирателям в Нью-Гэмпшире на прошлой неделе, с призывом не голосовать на праймериз в своем штате. Первоначально не было ясно, какая технология использовалась для копирования голоса Байдена, но тщательный анализ, проведенный охранной компанией Pindrop, показал, что злоумышленники использовали инструменты ElevanLabs.

Охранная фирма удалила фоновый шум и очистила звук звонка робота, прежде чем сравнить его с образцами более чем 120 технологий синтеза голоса, используемых для создания дипфейков. Генеральный директор Pindrop Виджей Баласубраманьян рассказал Wired, что «на 99 процентов оказалось, что это ElevenLabs». Bloomberg сообщает, что компания была уведомлена о выводах Pindrop и продолжает расследование, но уже выявила и заблокировала аккаунт, создавший фейковый звук. ElevenLabs сообщила новостной организации, что не может комментировать саму проблему, но что она «призвана предотвращать неправомерное использование инструментов аудио AI и [that it takes] любые случаи неправильного использования крайне серьезны».

Поддельный звонок робота Байдена показывает, как технологии, которые могут имитировать чужой облик и голос, могут быть использованы для манипулирования голосами на предстоящих президентских выборах в США. «Это лишь верхушка айсберга того, что можно сделать в отношении подавления избирателей или нападений на работников избирательных комиссий», — сказала The Hill Кэтлин Карли, профессор Университета Карнеги-Меллон. «Это было почти предвестником того, чего нам следует ожидать в ближайшие несколько месяцев».

Интернету потребовалось всего несколько дней после того, как ElevenLabs запустила бета-версию своей платформы, чтобы начать использовать ее для создания аудиоклипов, которые звучат так, будто знаменитости читают или говорят что-то сомнительное. Стартап позволяет клиентам использовать свою технологию для клонирования голосов для «художественных и политических выступлений, способствующих общественным дебатам». Его страница безопасности предупреждает пользователей, что они «не могут клонировать голос в оскорбительных целях, таких как мошенничество, дискриминация, разжигание ненависти или для любой формы онлайн-злоупотреблений, не нарушая при этом закон». Но очевидно, что ему необходимо принять дополнительные меры защиты, чтобы не позволить злоумышленникам использовать его инструменты для влияния на избирателей и манипулирования выборами по всему миру.

Эта статья содержит партнерские ссылки; если вы нажмете на такую ссылку и совершите покупку, мы можем получить комиссию.